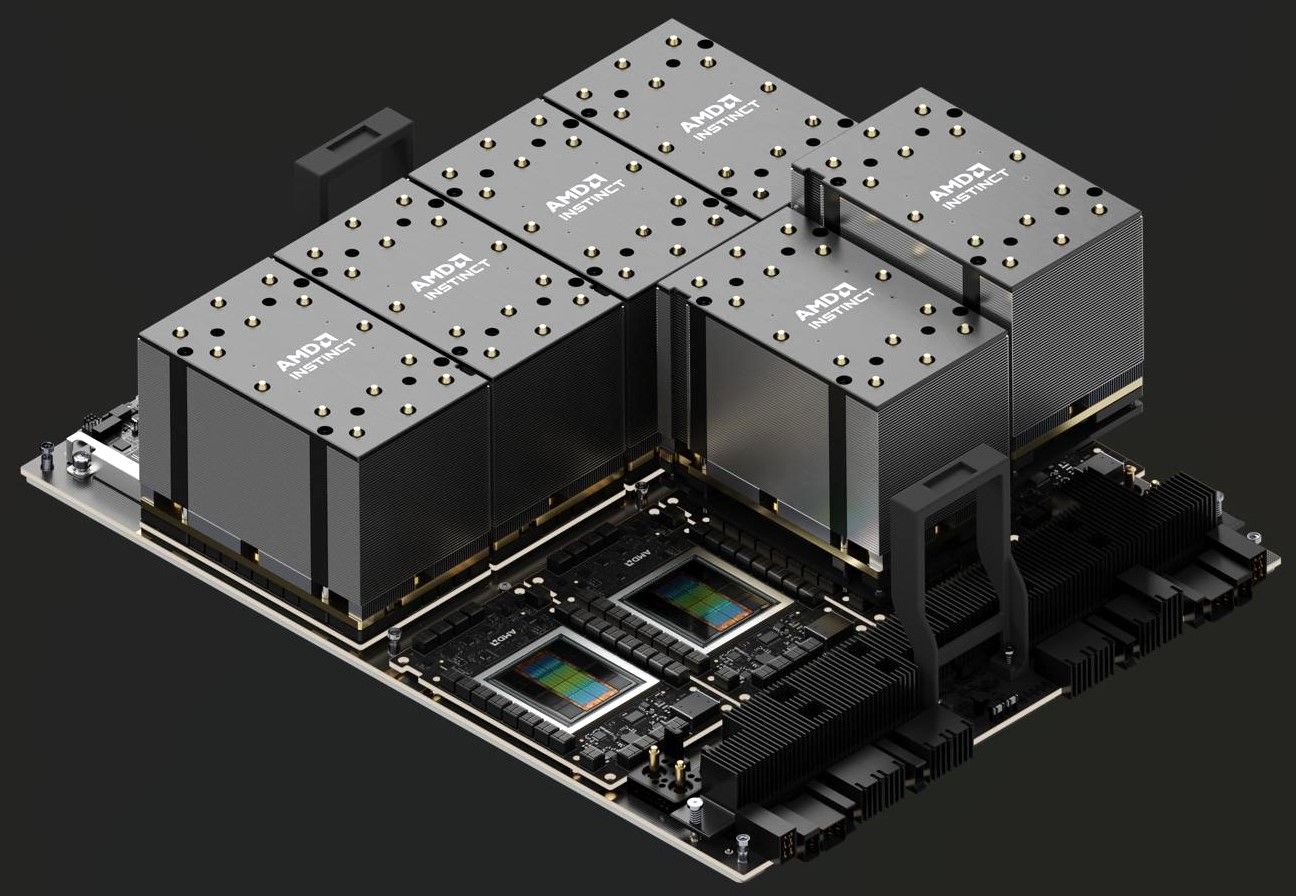

AMD Percepat Laju Inovasi dan Kepemimpinan AI Data Center dengan Roadmap GPU AMD Instinct yang Diperluas

Surabaya, Kabarindo- Dalam gelaran Computex 2024 di Taipei, Taiwan,, AMD memamerkan momentum perkembangan jajaran akselerator AMD Instinct yang disampaikan oleh Chair dan CEO AMD, Dr. Lisa Su.

AMD meluncurkan roadmap akselerator AMD Instinct multi-tahun yang diperluas, menghadirkan langkah kepemimpinan kinerja AI dan kemampuan memori di setiap generasi.

Roadmap yang diperbarui mulai akselerator AMD Instinct MI325X baru yang akan tersedia pada kuartal IV/2024. Berikutnya, AMD Instinct MI350 series, bertenaga arsitektur AMD CDNA 4 baru yang diharapkan tersedia pada 2025, hingga peningkatan performa inferensi AI 35x dibandingkan AMD Instinct MI300 Series dengan arsitektur AMD CDNA 3.. Kemudian AMD Instinct MI400 series bertenaga arsitektur AMD CDNA “Next” yang diharapkan tersedia pada 2026,

Brad McCredie, Corporate Vice President, Data Center Accelerated Compute AMD, mengatakan akselerator Instinct MI300X melanjutkan adopsi yang kuat dari berbagai mitra dan pelanggan termasuk Microsoft Azure, Meta, Dell Technologies, HPE, Lenovo dan lainnya, yang merupakan hasil langsung dari kinerja dan proposisi nilai akselerator AMD Instinct MI300X.

“Dengan rangkaian produk tahunan yang diperbarui, kami terus berinovasi dengan memberikan kemampuan dan kinerja kepemimpinan yang diharapkan oleh industri AI dan pelanggan untuk mendorong evolusi berikutnya dalam pelatihan dan inferensi AI data center,” ujarnya pada Rabu (5/6/2024).

Ekosistem software AMD AI makin kuat

Open software stack AMD ROCm 6 terus berkembang dan memungkinkan akselerator Instinct MI300X mendorong kinerja mengesankan untuk beberapa LLM paling populer. Pada server yang menggunakan delapan akselerator AMD Instinct MI300X dan ROCm 6 yang menjalankan Meta Llama-3 70B, pelanggan bisa mendapatkan kinerja inferensi dan pembuatan token 1,3x lebih baik dibandingkan pesaing. Pada satu akselerator AMD Instinct MI300X dengan ROCm 6, pelanggan bisa mendapatkan kinerja inferensi dan throughput pembuatan token yang lebih baik dibandingkan kompetitor sebesar 1,2x pada Mistral-7B. AMD juga menyoroti bahwa Hugging Face, penyimpanan terbesar dan terpopuler untuk model AI, kini menguji 700.000 model terpopuler setiap malam untuk memastikan model tersebut berfungsi langsung pada akselerator Instinct MI300X. Selain itu, AMD melanjutkan pekerjaan upstream ke dalam kerangka AI populer seperti PyTorch, TensorFlow dan JAX.

Akselerator baru dan roadmap tahunan

AMD mengungkapkan langkah tahunan terbaru untuk roadmap akselerator AMD Instinct guna memenuhi permintaan yang terus meningkat akan komputasi AI yang lebih banyak. Hal ini akan membantu memastikan bahwa akselerator AMD Instinct mendorong pengembangan model AI terdepan generasi berikutnya. Roadmap tahunan AMD Instinct yang diperbarui menyoroti:

Akselerator AMD Instinct MI325X baru, yang menghadirkan memori HBM3E 288 GB dan bandwidth memori 6 terabyte per detik, menggunakan desain server Universal Baseboard standar industri yang sama dengan yang digunakan oleh AMD Instinct MI300 series, dan tersedia pada kuartal IV/2024. Akselerator ini akan memiliki kapasitas memori dan bandwidth terdepan di industri, masing-masing 2x dan 1,3x lebih baik dibandingkan kompetitor dan kinerja komputasi 1,3x lebih baik dibandingkan kompetitor.

Produk pertama dalam AMD Instinct MI350 Seri, akselerator AMD Instinct MI350X, didasarkan pada arsitektur AMD CDNA 4 dan diharapkan akan tersedia pada 2025. Produk ini akan menggunakan desain server Universal Baseboard standar industri yang sama dengan akselerator MI300 Series lainnya dan akan dibuat menggunakan teknologi proses 3nm yang canggih, mendukung tipe data AI FP4 dan FP6, serta memiliki memori HBM3E hingga 288 GB.

Arsitektur AMD CDNA “Next”, yang akan mentenagai akselerator Instinct MI400 Series, diharapkan tersedia pada 2026 dengan menyediakan fitur dan kemampuan terbaru yang akan membantu membuka performa dan efisiensi tambahan untuk inferensi dan pelatihan AI skala besar.

Terakhir, AMD menyoroti permintaan akselerator AMD Instinct MI300X yang terus bertumbuh dengan banyaknya mitra dan pelanggan yang menggunakan akselerator tersebut untuk mendukung beban kerja AI yang berat, termasuk:

*Microsoft Azure menggunakan akselerator untuk layanan Azure OpenAi dan Azure ND MI300X V5 virtual\machines terbaru.

*Dell Technologies menggunakan akselerator MI300X di dalam PowerEdge XE9680 untuk beban kerja AI Perusahaan.

*Supermicro menyediakan berbagai solusi dengan akselerator AMD Instinct.

*Lenovo mendukung inovasi Hybrid AI dengan ThinkSystem SR685a V3.

*HPE menggunakannya untuk mempercepat beban kerja AI di dalam HPE Cray XD675.

Foto: istimewa